最近,DeepSeek可以說是火遍大江南北,其強大的推理能力,無疑是我們工作生活的好幫手。但超高的熱度也帶來了甜蜜的煩惱,它的官網經常出現“服務器繁忙”的提示,原因是承載能力有限。

那怎麼樣把不卡頓,不繁忙的DeepSeek“種”在自己的電腦或者手機裏呢?今天就給大家分享兩種方法。

1、硅基流動API調用法

這種方法的優勢:不挑配置,網頁、手機端都能用,響應速度也比較快,能用滿血版模型(671B的DeepSeek)

這種方式的不足:需要聯網,極少數時候響應偏慢(也是因爲用的人太多了),要付費(不多)。

硅基流動是一個AI雲技術平臺,你可以理解爲,它在雲端部署了諸如DeepSeek、Stable Diffusion這樣的模型,開發者和個人用戶可以通過調用它的api,來使用這些模型。

首先,打開硅基流動官網:

https://cloud.siliconflow.cn/i/vaWtvcpf

這是我的邀請鏈接(沒收它家的錢),可以用它註冊一個賬號(我的邀請碼:vaWtvcpf)

如果首次註冊忘記輸入邀請碼了,第二次登錄前再輸出邀請碼,也是可以享受2000萬Tokens的!

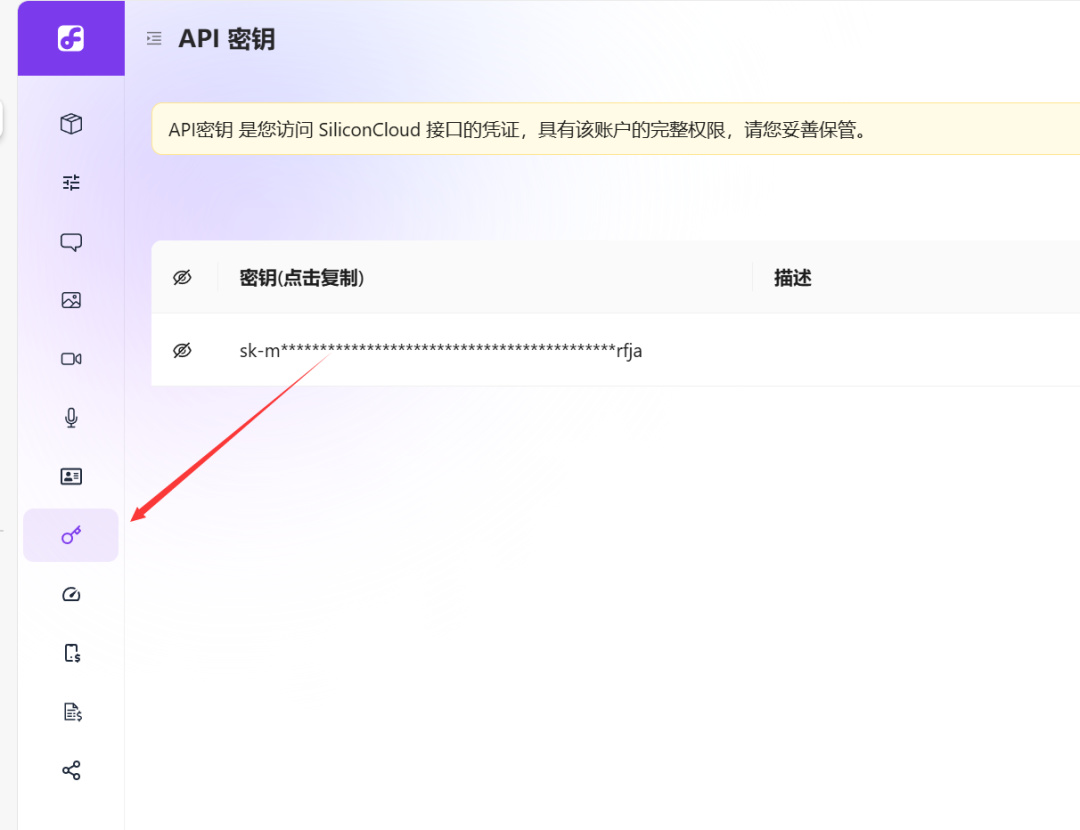

註冊完成之後,來到“模型廣場官網”,點擊左下角“小鑰匙”這裏:

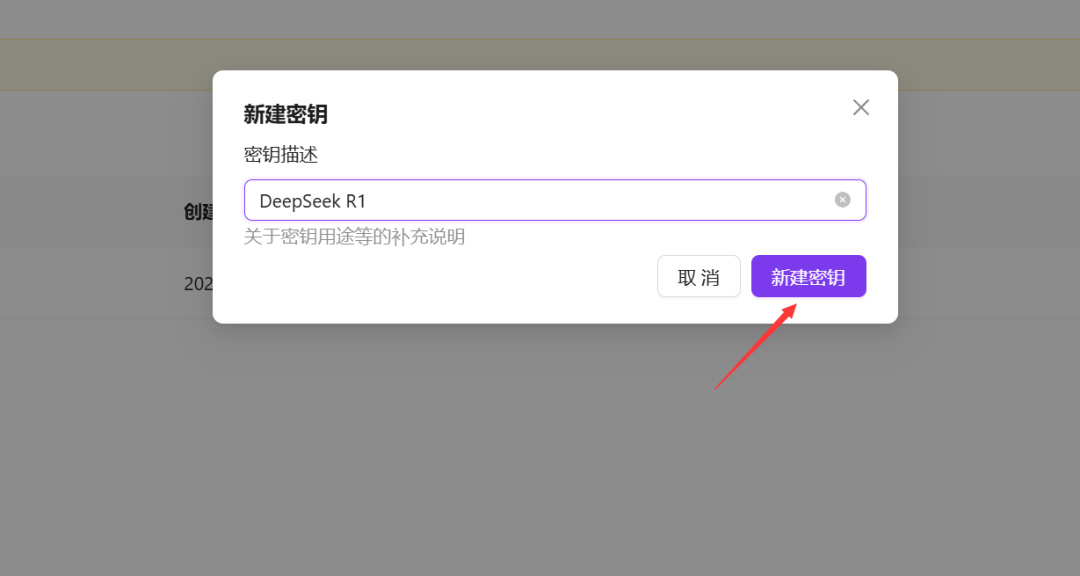

再點擊右上角“新建API密鑰”,新建一個API密鑰,名字隨意。

註冊好了之後,如果是網頁端,可以使用ChatBox:

https://chatboxai.app/zh#download

直接進入網頁端,點擊左下角“設置”按鈕:

模型選“DeepSeek-R1”,不要選Pro開頭那個:

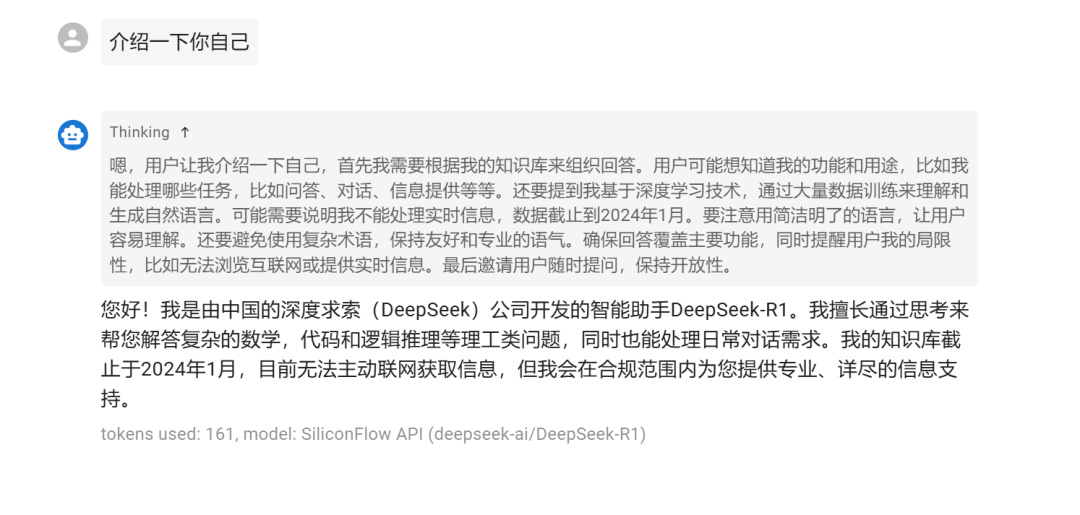

然後返回對話頁面,就能開始用了:

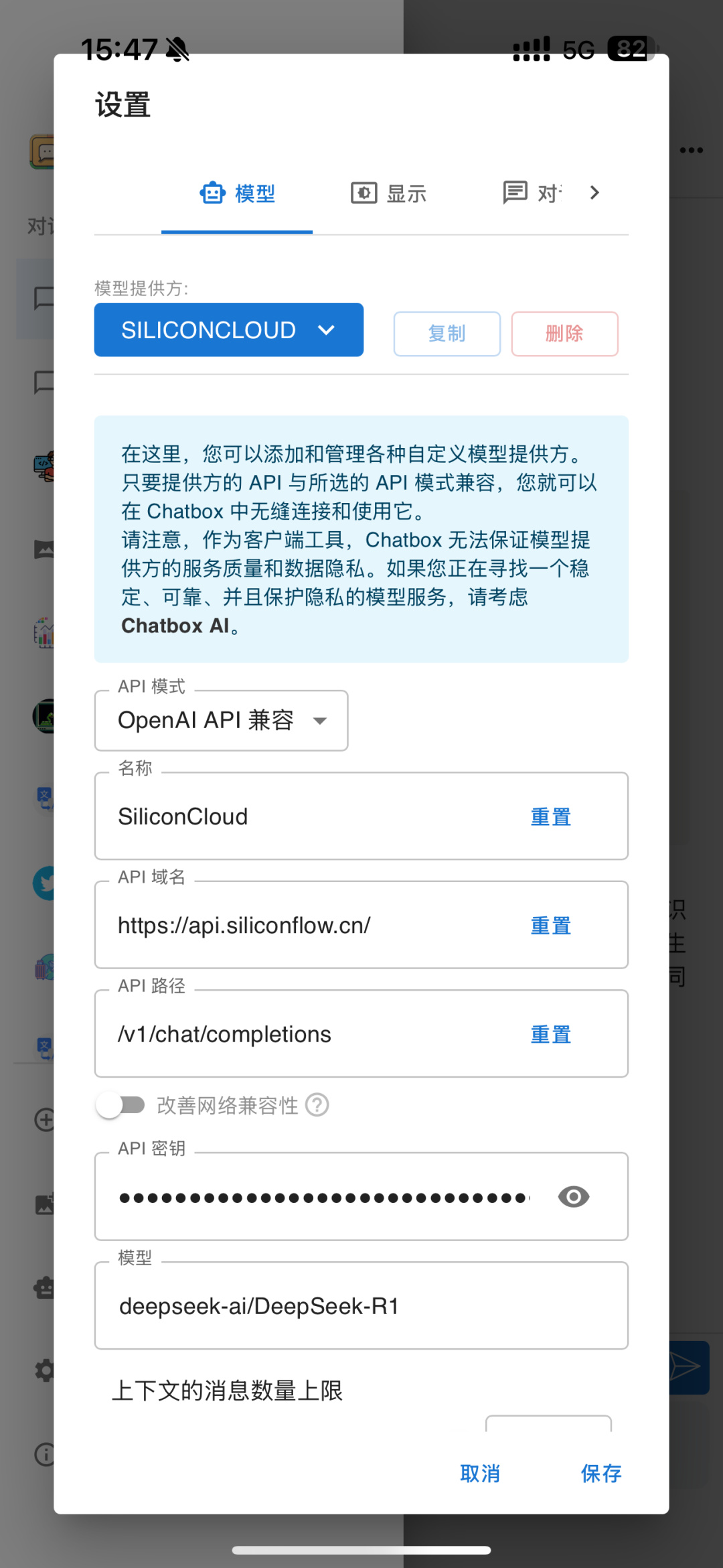

app端也是一樣的,下載並安裝ChatBox APP,進入“設置”,按照下圖輸入密鑰和API域名、路徑。

api域名:https://api.siliconflow.cn/

api路徑:/v1/chat/completions

如果你是桌面端使用的話,我個人推薦用Cherry Studio,下載地址:

https://www.cherry-ai.com/

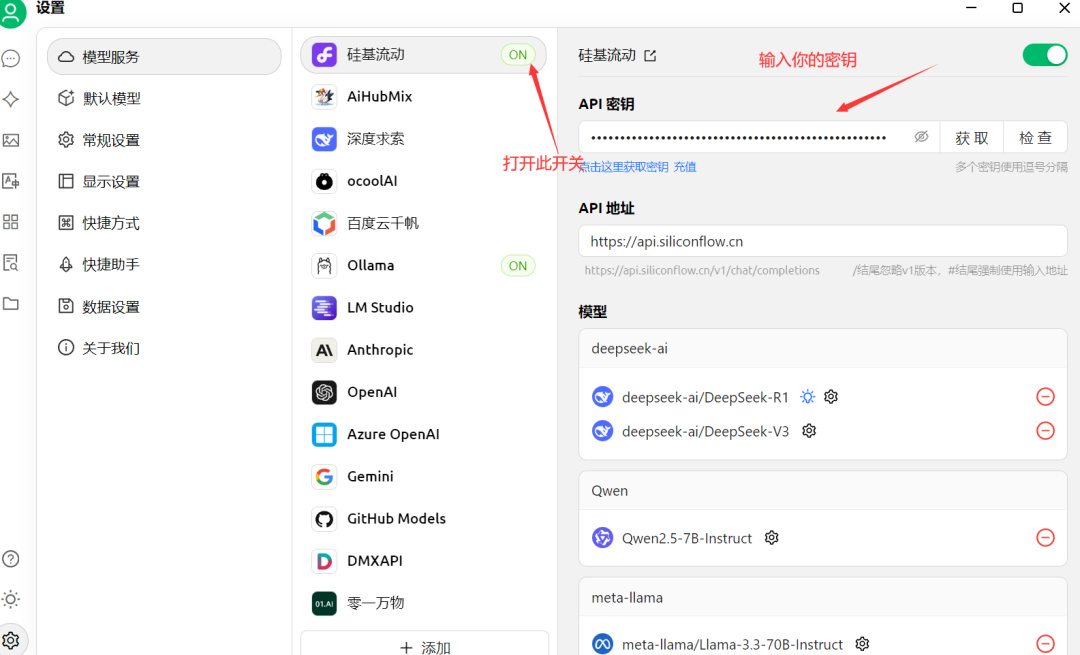

下載安裝之後,同樣打開設置:

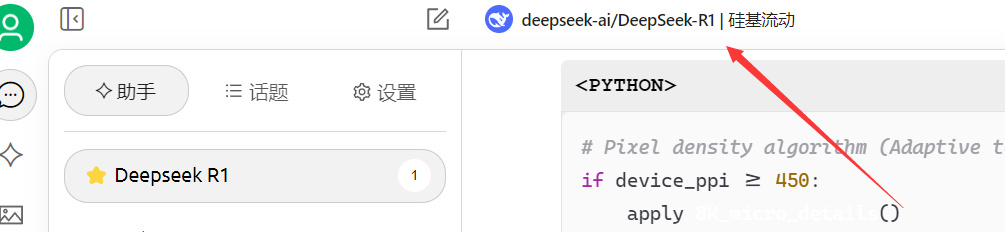

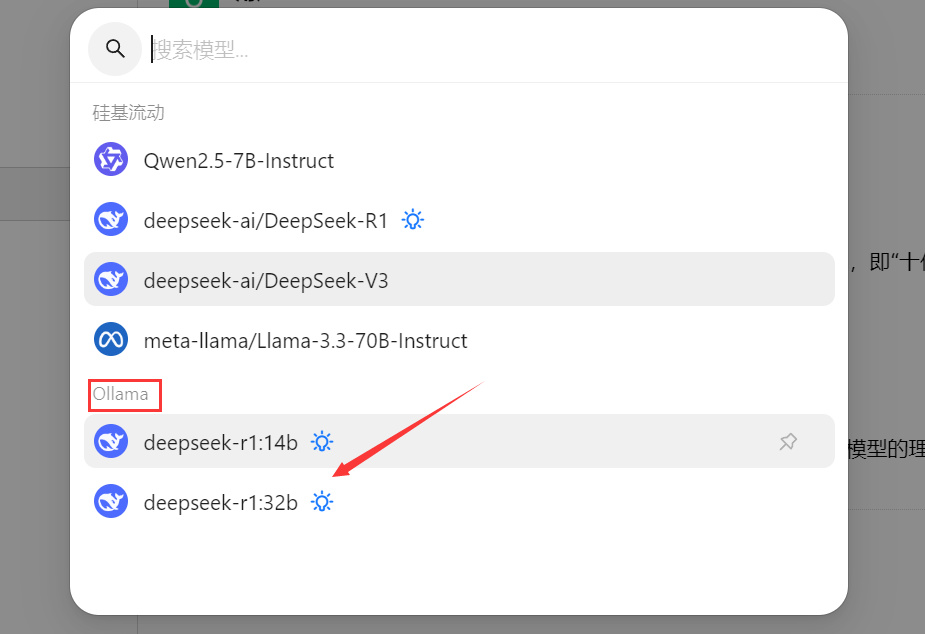

然後點擊這裏,選擇帶“硅基流動”的DeepSeek R1,就可以了。

怎麼樣,是不是超級簡單!憑藉着超簡單的使用,硅基流動也是一炮而紅,成爲了現在使用DeepSeek的好夥伴。除了硅基流動之外,納米搜索,騰訊元寶等多款AI工具,也都接入了滿血的DeepSeek,大家可以都下載來試用一下,看看哪個好用。

2、Ollama本地部署法

這種方法的優勢:真本地部署,無需聯網,沒有任何信息安全隱患

這種方式的不足:對配置要求非常高(主要是顯卡顯存),且只能部署“蒸餾版”(也就是殘血版)模型。

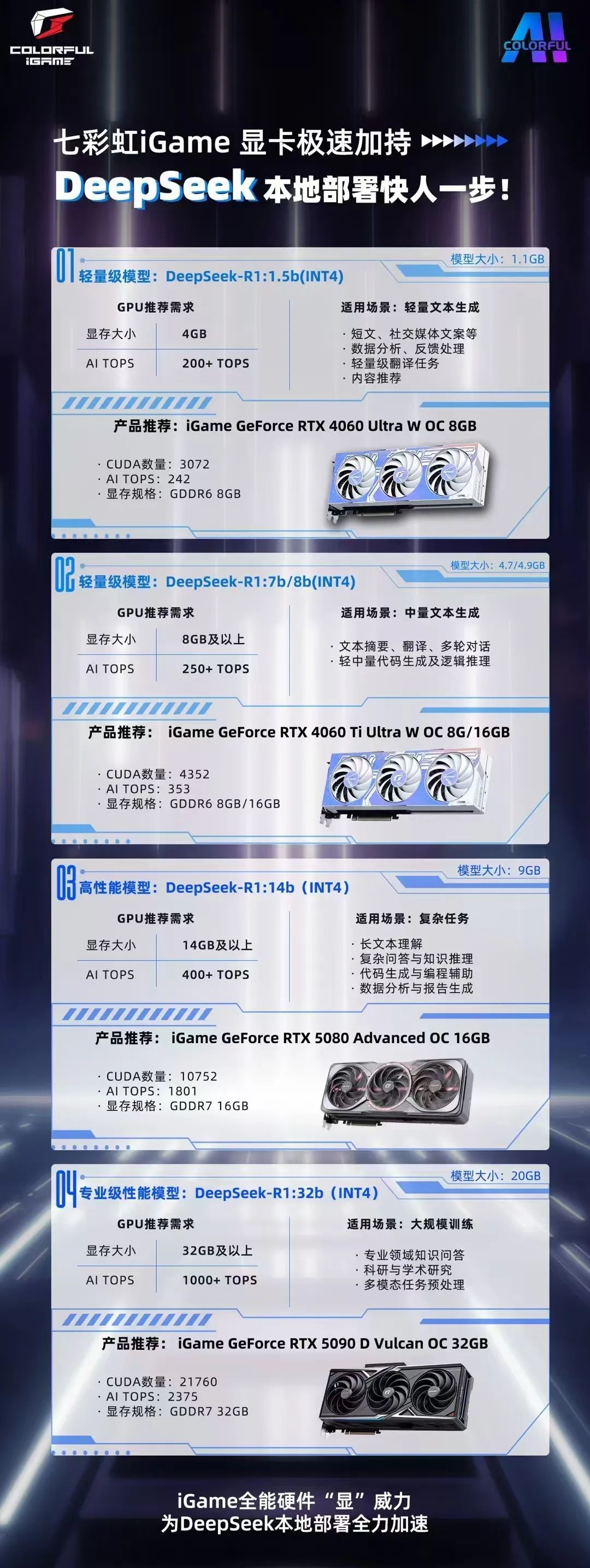

這種方法很喫顯存,看看七彩虹官方給出的參考吧:

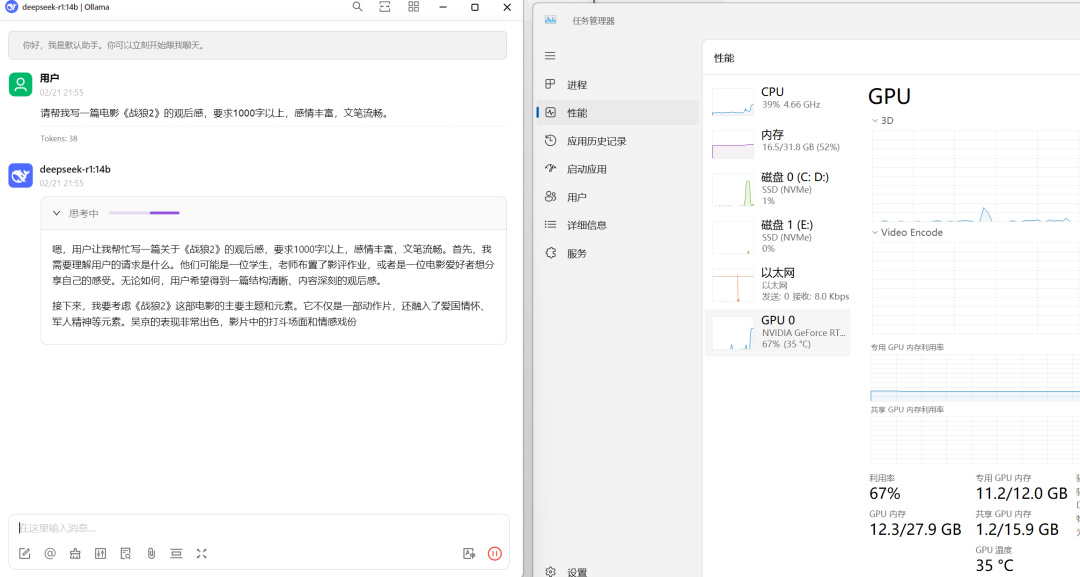

哪怕是現在最強大的消費級顯卡,RTX5090D,擁有32G顯存,也只能部署32B的模型。我自己實測,12G顯存的RTX4070Ti,部署32B明顯喫力,14B流暢度OK,也基本上能滿足需求。

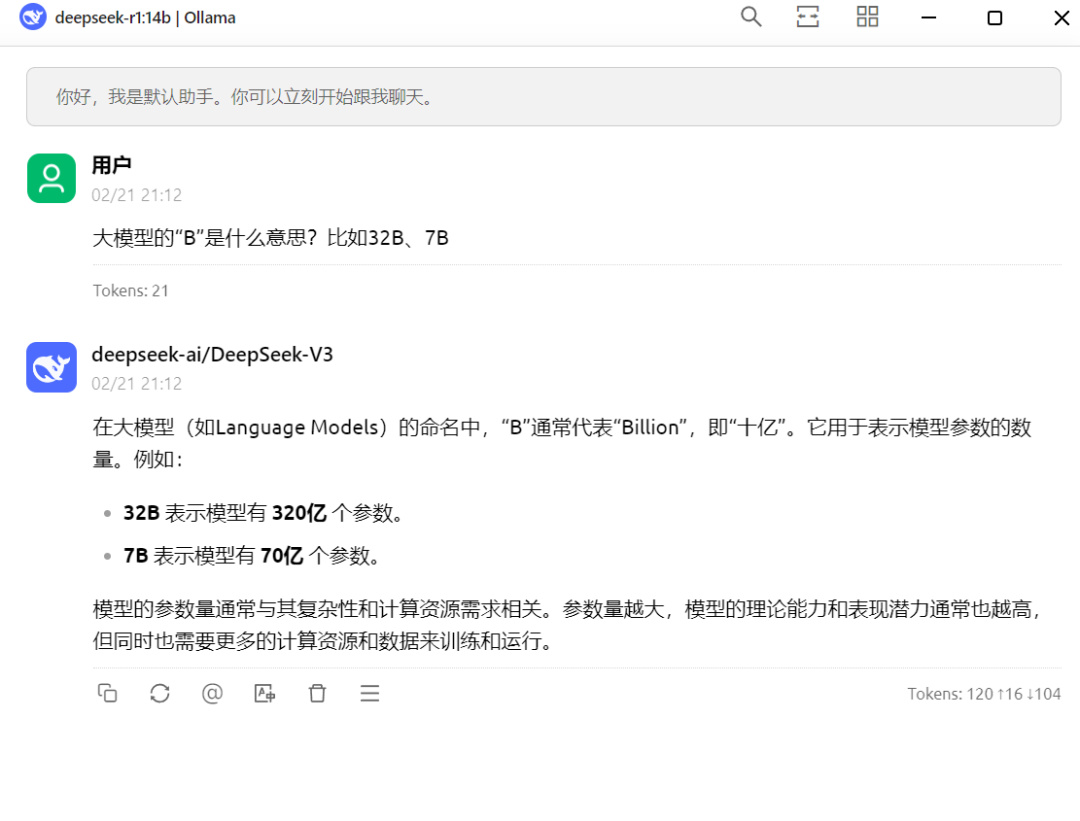

*這個“B”通常代表“Billion”,即“十億”。它用於表示模型參數的數量。B前面的數字越大,代表模型參數越多,模型的理論能力和表現潛力通常也越高,表現爲給出的結果越精準,越專業,但同時也需要更多的計算資源和數據來訓練和運行。

顯存8G以下推薦部署1.5B的;顯存8G推薦部署7B/8B的;顯存12-16G可以考慮部署14B的;顯存20G以上,可以部署32B的,再往上就不是我們一般用戶考慮的事情了。

本地部署DeepSeek通過Ollama進行,先下載一個Ollama:

默認安裝在C盤,最好不要更改安裝盤符,否則要重新配置環境變量。

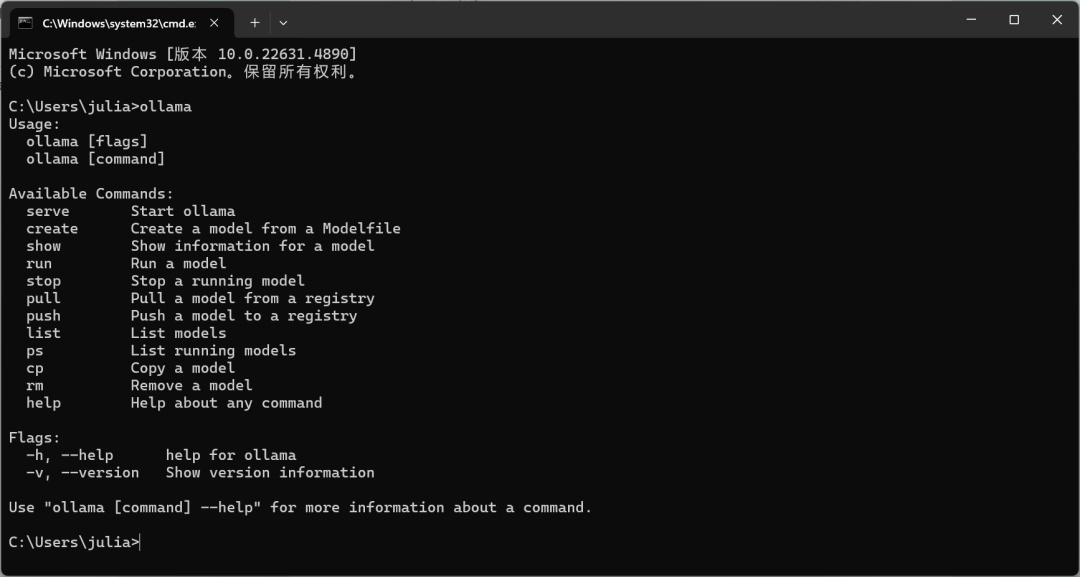

下載安裝完成之後,按win+R,輸入“cmd”進入命令提示行,如果出現下面的文字,說明已經安裝成功了,可以進入下一步。

如果提示安裝失敗的話,可能需要配置一下環境變量:

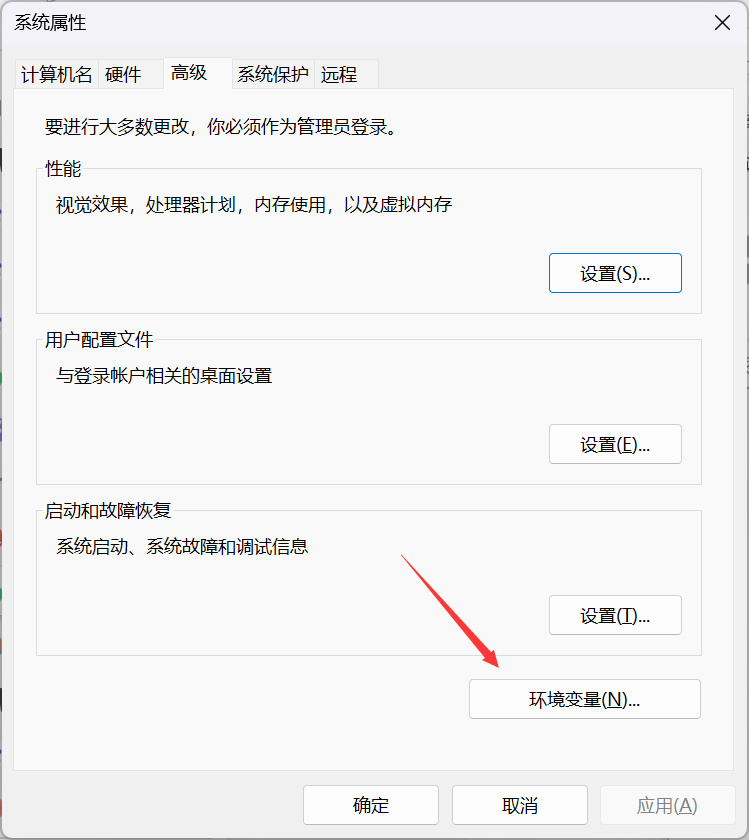

點擊系統設置-系統-系統信息,進入“高級系統設置”:

點擊“環境變量”:

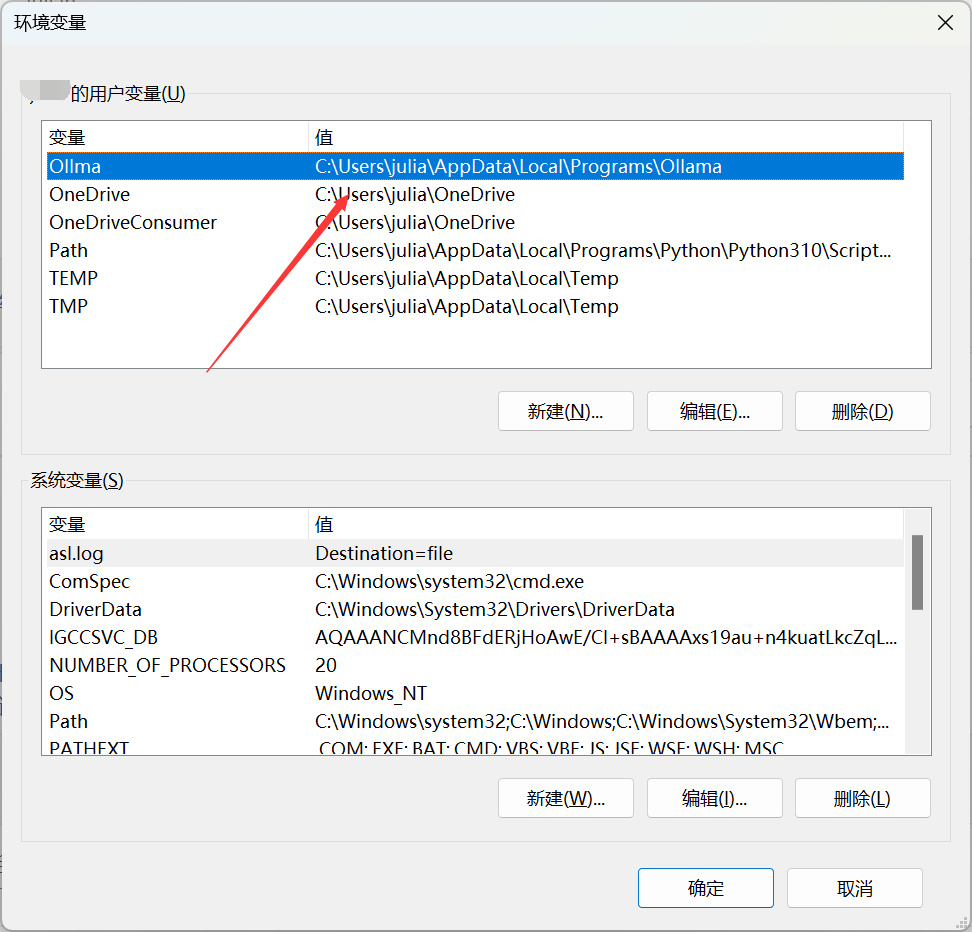

如果沒有Ollama的環境變量,可以自己新增一個,變量名字隨意,變量值定位到Ollama的安裝目錄即可:

新增完環境變量之後,如果還是有問題的話,重啓下電腦,應該就可以了。

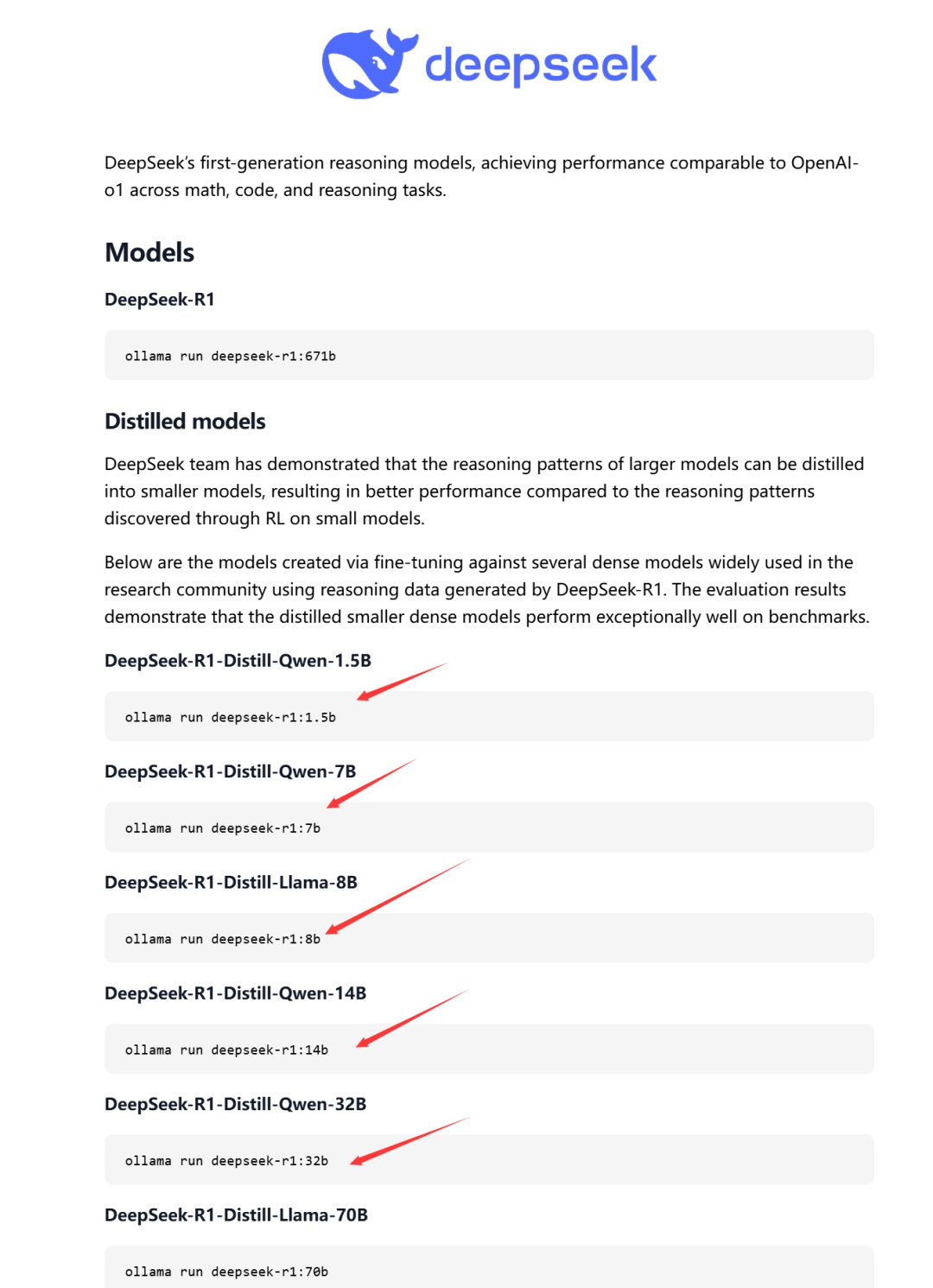

成功安裝好Ollama之後,win+R,輸出“cmd”,再輸入“Ollama”命令,啓動Ollama。這個時候我們再回到官網找模型,點擊這個鏈接:

點開之後往下滑,來到“Models”這裏:

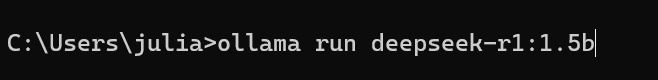

找到自己想要的那個模型(根據自己的電腦顯存選),然後複製這個鏈接,來到命令提示行,粘貼:

按下回車,會自動下載,下載完即可在命令提示行裏直接對話了。

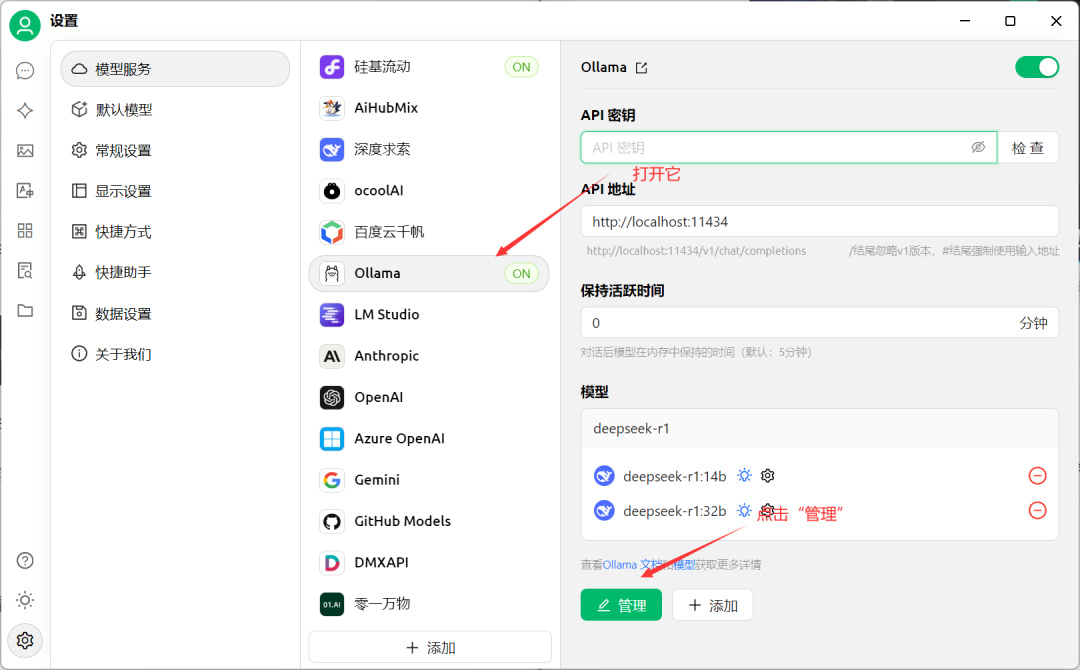

但總不可能每次都用命令提示行吧,有沒有類似於官網的界面呢?當然有,就是我前面提到的Cherry Studio:

https://www.cherry-ai.com/

下載安裝完成之後,打開軟件,進入設置打開Ollama的開關,再進入“管理”界面:

Cherry Studio能直接識別到Ollama裏安裝的模型,點擊“+”號就可以了:

然後回到主界面對話框,把模型選擇爲Ollama的DeepSeek模型:

如果你同時部署了硅基流動和Ollama的話,可以在這裏切換使用,一般我處理比較複雜的任務,就會用硅基流動那個671B的模型,而如果只是簡單的任務,用本地的14B模型足矣,不用錢,而且無需聯網,更穩定。

切換完之後,回到主界面開始對話,完成!

顯存喫得很滿,明顯是本地在運行的:

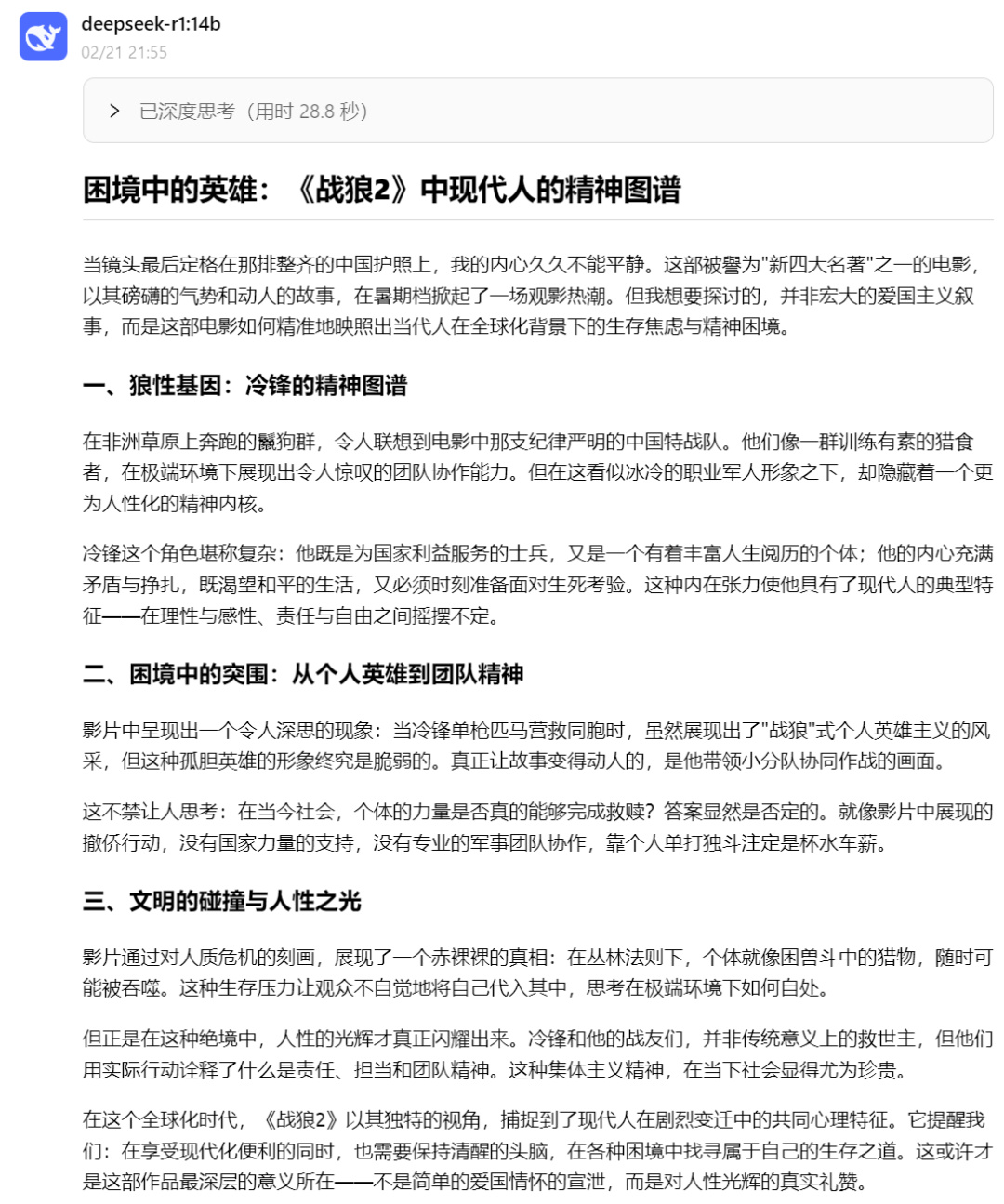

其實14B已經很夠用了,看看它生成的《戰狼2》電影觀後感吧:

好了,今天給大家分享了我自己部署DeepSeek的方案,大家可以參考一下。DeepSeek要想用好,核心就是Prompt(提示詞),這個網站是官方的Prompt庫,大家可以先看看:

https://api-docs.deepseek.com/zh-cn/prompt-library/

最後,贈送大家一份長達104頁,實用的DeepSeek使用指南,來自清華的,後臺私信輸入“deepseek”獲取下載鏈接(這類材料網上免費的非常多,關於DeepSeek的教程也有一堆,沒必要被那些賣課的割韭菜!)

AI毫無疑問是這個時代,人人都要會的實用工具,後續我也會在這裏,給大家分享一些我的使用心得

我們下期見,拜拜!

更多遊戲資訊請關註:電玩幫遊戲資訊專區

電玩幫圖文攻略 www.vgover.com