2025年3月,当谷歌首席科学家Jeff Dean在社交媒体上宣布与计算机历史博物馆(CHM)联合公开AlexNet原始代码时,整个AI社区仿佛经历了一场数字文艺复兴。这份尘封13年的代码(GitHub链接:https://github.com/computerhistory/AlexNet-Source-Code),不仅是深度学习革命的"创世纪"手稿,更是一部用C++和CUDA写就的技术史诗。

这份代码的特殊性在于其"原汁原味"——不同于GitHub上其他根据论文复现的版本,它完整保留了2012年参赛时的工程细节:从数据增强时RGB通道的随机扰动,到两个GTX 580 GPU间的参数同步策略,甚至注释中潦草记录的深夜调试心得。HuggingFace联合创始人Thomas Wolf兴奋地指出:"这些实验日志式的注释,就像福尔摩斯探案时发现的烟灰,透露着思维进化的蛛丝马迹。"

三剑客的"暴力美学":技术细节中的时代烙印

透过代码仓库中的imagenet.py文件,我们得以窥见那个算力匮乏年代的智慧结晶。AlexNet的架构设计处处体现着"戴着镣铐跳舞"的巧思:

GPU分治策略

受限于单卡3GB显存,网络被拆分为两条并行计算流,第三层卷积巧妙融合双路特征,这种"分而治之"的架构后来启发了分布式训练范式

数据增强的穷举艺术

代码中通过随机裁剪生成2048倍扩增数据,这在SSD硬盘尚未普及的2012年,堪称用算法弥补存储缺陷的典范

LRN层的生物学隐喻

局部响应归一化代码段中的跨通道竞争机制,暗合视觉皮层神经元侧抑制原理,这种仿生设计在当今的批归一化技术中仍可见其基因

特别值得玩味的是训练脚本中的learning_rate设置:初始值为0.01,每10万次迭代衰减10倍。这种朴素的策略与当今复杂的自适应优化器形成鲜明对比,印证了Hinton那句名言:"有时候,简单到不好意思发表的idea,反而能改变世界。"

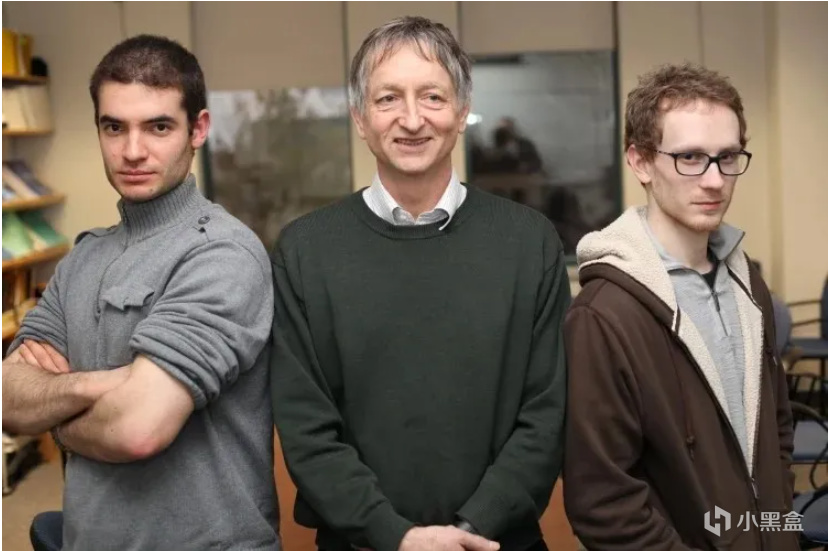

诺奖得主的"车库创业":从多伦多实验室到硅谷权力游戏

代码公开背后是一段跨越五年的"技术外交":2020年CHM策展人Hansen Hsu联系Alex Krizhevsky时,这位低调的天才早已淡出学界,最终由Hinton在谷歌与博物馆间斡旋完成授权。这让人想起三位创始人的迥异人生轨迹:

Geoffrey Hinton

心理学出身的"AI教父",在代码注释中留下"尝试用动量项缓解鞍点困境"的笔记,这项技术后来成为优化算法的标配。2024年诺贝尔物理学奖的颁奖词特别提及:"他证明了智能的本质可能比量子纠缠更令人震撼"

Ilya Sutskever

从AlexNet到ChatGPT,这位OpenAI联合创始人始终保持着对scale的信仰。他在原始代码中编写的多GPU同步接口,为后来的分布式训练埋下伏笔

Alex Krizhevsky

CIFAR数据集之父却在巅峰期隐退,其代码中的crop_mirror_proc函数至今仍是数据增强的黄金标准,而他本人却选择成为算法世界的"塞林格"

技术史的分水岭:当ImageNet遇见CUDA

回望2012年ImageNet竞赛,AlexNet的胜利本质上是"数据×算力×算法"的乘积效应:

数据维度

代码中硬编码的128万训练样本,在当年堪称"大数据",而今仅相当于Llama 3训练数据的0.002%

算力革命

两个GTX 580(共6GB显存)训练五天,其计算量放在2025年仅需租用云端A100实例15分钟,成本不足5美元

算法突破

ReLU激活函数的引入使训练速度提升6倍,而dropout_layer.cpp中0.5的随机失活率,至今仍是全连接层的默认设置

更具历史意义的是,这份代码奠定了现代AI研究的工程范式:

开源文化

尽管受限于公司产权,但其技术细节的透明化启发了后来的PyTorch/TensorFlow生态

硬件协同

CUDA代码中的核函数优化,直接推动了英伟达从图形芯片商向AI算力巨头的转型

benchmark驱动

ImageNet的TOP-5评估指标,为后续的SQuAD、GLUE等评估体系树立了模板

注释里的未来预言:被忽视的技术遗产

在readme.txt中,开发者留下了一段耐人寻味的注释:"尝试在第三个卷积层引入跨通道交互,但梯度爆炸问题未解决——或许需要更智能的初始化?" 这个未竟的设想,在十年后的Transformer注意力机制中得到完美实现。

更令人拍案的是数据预处理部分的pca_noise函数:通过对RGB空间进行主成分分析并添加高斯噪声,这在2012年被视为工程trick的技术,如今在扩散模型的降噪器设计中焕发新生。就连当年被迫启用的双GPU架构,也意外地为MoE(混合专家)模型的并行计算提供了早期蓝本。

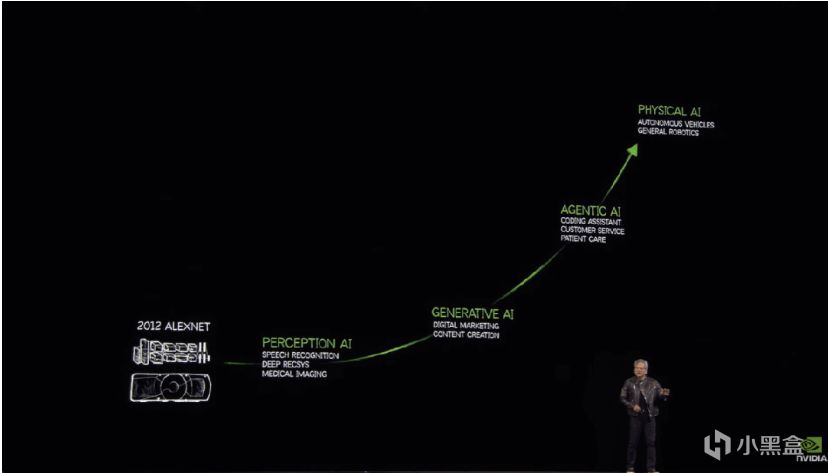

从AlexNet到AGI:一条代码流淌的长河

站在2025年回看,AlexNet的遗产早已超越计算机视觉领域:

自然语言处理

BERT中的位置编码可追溯至AlexNet的空间金字塔池化

强化学习

AlphaGo的蒙特卡洛树搜索,其并行评估架构与当年的多GPU策略异曲同工

生成式AI

Stable Diffusion的U-Net架构中,跳跃连接的思想源自AlexNet的跨层特征融合

正如黄仁勋在GTC 2025的主题演讲中所说:"我们今天拆解的每个transformer block,都能在AlexNet的某个代码段找到基因片段。"

更多游戏资讯请关注:电玩帮游戏资讯专区

电玩帮图文攻略 www.vgover.com