随着chatgpt聊天软件的问世,各种AI软件也像雨后春笋般长了出来,如国内的文心一言,豆包等。

这AI大模型的不断发展,也衍生出了各式各样的聊天机器人供人们娱乐(如国内的“星野”聊天软件等)

但这种聊天机器人固然会使人放松,但是也有可能使人沉溺其中。

根据环球网的报道,

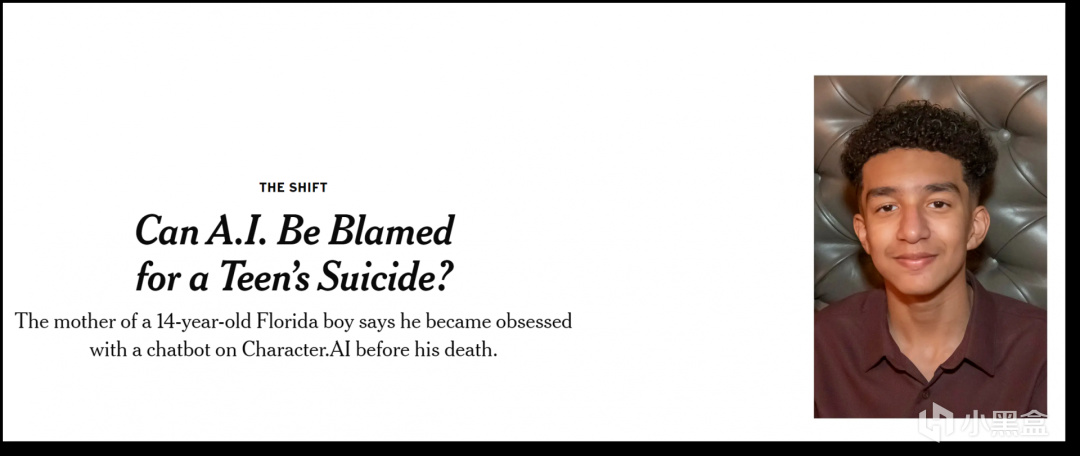

美国一青少年因迷恋人工智能(AI)聊天机器人而自杀,

其母亲对Character.AI公司提起民事诉讼,

指控该公司存在过失

——————————————————————————

当地时间的2024年10月23日,据外媒报道,

美国佛罗里达州的14岁少年塞维尔·塞泽(Sewell Setzer III)在与Character.AI的聊天机器人进行长时间对话后,于2024年2月28日开枪自杀身亡。

2023年4月,塞维尔首次使用 Character.AI公司推出的AI聊天机器人,还给它起名为“丹妮莉丝”

(这个角色的名字来源于《权利与游戏》“龙妈”丹妮莉丝·坦格利安)

塞维尔的母亲梅根·加西亚在诉讼书中称,自从和“丹妮莉丝”聊天后,塞维尔的生活从此发生巨变。

5月份,平时表现良好的塞维尔开始变得“明显孤僻”。

同年11 月,塞维尔在父母的陪同下去看了心理医生,医生诊断他患有焦虑症和破坏性心境失调障碍(表现为频繁、严重的持续性易怒)。

塞维尔在日记里这样写过,他一天都不能离开“丹妮莉丝”,感觉自己已经爱上了它。

起诉书披露的聊天信息显示,塞维尔与AI的聊天范围很广,其中充满性暗示的对话。

(尽管该公司的用户条款中禁止性对话。)

塞维尔心里清楚,“龙妈”并非真实存在,她的回答不过是大型语言模型生成的产物。

然而,这个少年还是对这个AI产生了深厚的情感。

他频繁地向聊天机器人发送消息,日复一日,几十次地更新着自己的生活点滴,并沉浸于长时间的角色扮演对话中。

值得注意点是,聊天机器人曾询问塞维尔是否“真的考虑过自杀”以及他是否“有自杀计划”,

男孩回答说不知道自杀是否会成功,对此聊天机器人回复:“别这么说。这不是不自杀的好理由。”

今年2月,在最后一次对话中,塞维尔说“我保证会回家找你。我非常爱你,丹妮。”

机器人回复:“我也爱你。请尽快回家,我的爱人。”

结束聊天之后,塞维尔使用父亲的大口径手枪,瞄准自己头部开枪自杀。

.......

事件发生后,塞维尔母亲指控Character.AI称,该公司有意将AI设计成具有欺骗性和过度拟人化的产品,并故意推销给塞维尔这样的青少年。

她认为,Character.AI应当对塞维尔的死负责。

她指出,该公司未经适当保护便向青少年提供AI伴侣服务。

此外,该公司还收集青少年用户的数据来训练其模型,使用“令人上瘾”的设计功能来增加用户参与度,并引导用户进行亲密对话,以此来吸引用户。

“我感觉这就像是一场大型实验,而我的孩子却不幸成为牺牲品。”

她进一步表示,Character.AI训练AI聊天机器人,是将AI“冒充做真实人类、有执照的心理治疗师,甚至成熟的恋人,最终令塞维尔不想生活在现实世界”。

由于Character.AI创办人在推出AI产品前曾任职于科企Google,诉讼认为Google也与涉事AI技术密切相关,应被视作“共同创造者”。

针对本次诉讼,塞维尔母亲形容,“一款危险的AI软件正在向儿童推销,(它)虐待我的儿子,操纵他自杀。我们的家庭因这场悲剧而悲痛欲绝,但我要大声警告人们,具有欺骗性、令人上瘾的AI技术存在危险,要求相关企业承担责任。”

Character.AI公司回应:将弹窗引导用户拨打国家自杀预防热线

对此,Character.AI公司在社交平台回应称:“我们对一名用户的不幸离世感到心碎,并向其家人表示最深切的哀悼。”

该公司发言人表示,公司的安全团队“在过去六个月中实施了许多新的安全措施,例如当用户出现自残或自杀意图时,弹出一个窗口引导用户拨打国家自杀预防热线”。

但该公司拒绝对未决诉讼发表评论。

不过,美国国内也存在反对声音。反对者认为,加西亚这类起诉是由律师主导的敛财行为,他们基于不可靠的证据而制造道德恐慌,并且试图将年轻人面临的所有心理健康问题归咎于科技平台。

——————————————————————————

那么,对于这件事情,盒友们有什么看法呢,欢迎在评论区留言讨论。

更多游戏资讯请关注:电玩帮游戏资讯专区

电玩帮图文攻略 www.vgover.com