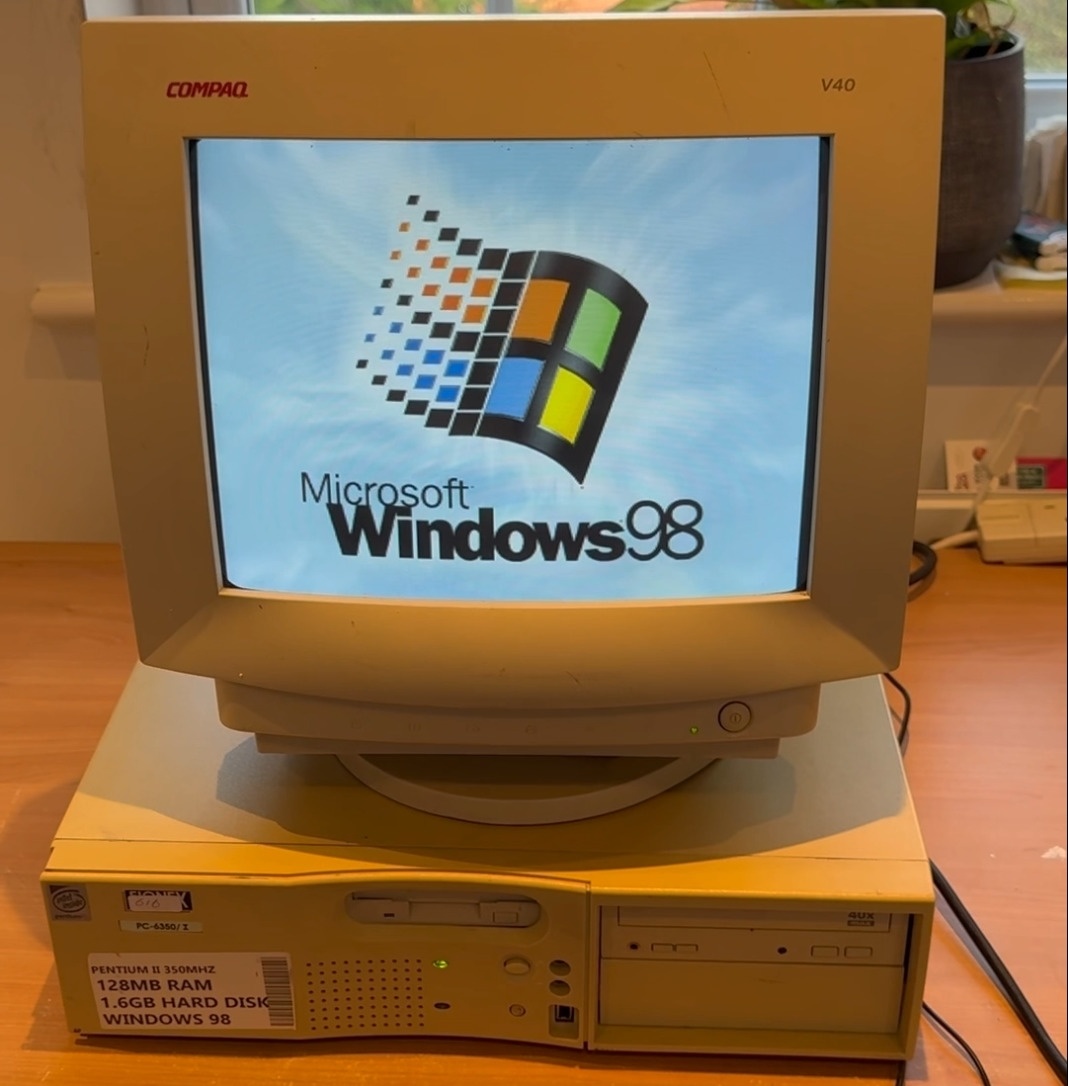

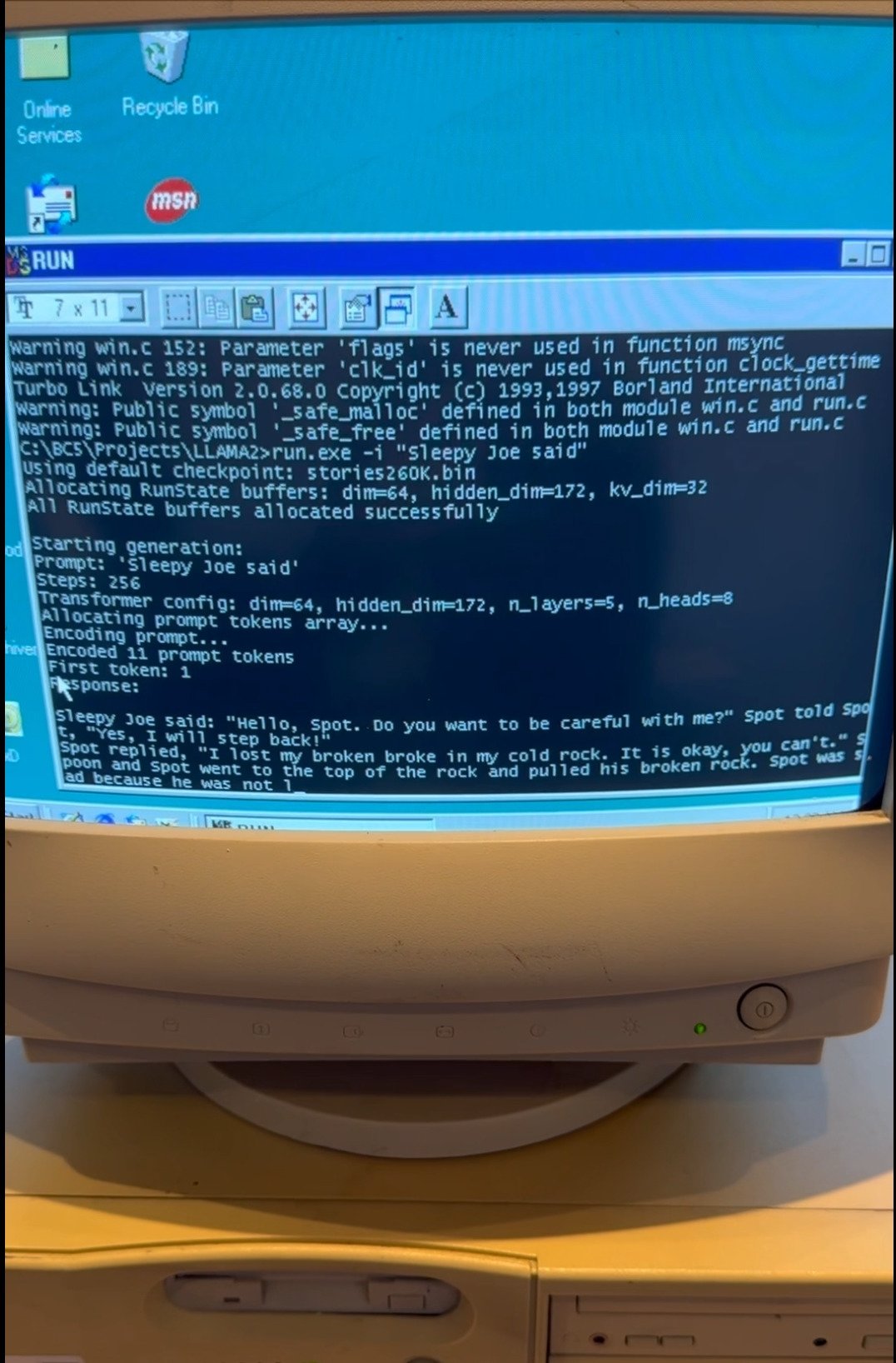

EXO Labs最近发布了一段令人惊叹的视频,展示了他们在一台拥有26年历史的老旧Windows 98奔腾2PC上成功运行大规模语言模型(LLM)。这台主频为350MHz的经典电脑不仅顺利启动了Windows 98操作系统,还成功启动了基于Andrej Karpathy的Llama2.c定制推理引擎。在运行该引擎时,EXO请求AI生成关于“Sleepy Joe”的故事,生成速度令人惊讶,超出许多人的预期。

这一项目背后有着更深远的背景。EXO Labs自成立以来,一直秉承“民主化AI”的理念,致力于通过开放的基础设施让AI技术不再被少数大型公司所垄断。由牛津大学的研究人员和工程师组成的EXO团队认为,大型企业主导AI领域可能会对社会、文化和真相产生不利影响。因此,他们的目标是让世界上任何地方的任何人都能在自己的设备上运行最先进的AI模型,这次在Windows 98上的演示正是这一理念的生动体现。

在文章中,EXO详细描述了他们如何将Llama模型成功移植到Windows 98上的过程。首先,他们购买了一台旧款Windows 98电脑作为实验基础,但从一开始就面临了不少挑战。例如,将数据从现代设备传输到这台老机器就成了一大难题,最终他们只能使用“老式FTP”协议,通过这台老PC的以太网端口进行文件传输。

更具挑战性的是如何将现代化的代码移植到Windows 98环境中。为了实现这一目标,EXO团队找到了Andrej Karpathy开源的Llama2.c推理代码,这是一个仅包含700行纯C代码的项目,可以运行Llama 2架构的推理任务。Karpathy,曾是特斯拉AI负责人,也是OpenAI创始团队成员,提供了这一重要资源。借助旧版Borland C++ 5.02 IDE和编译器,经过一些调整后,EXO将代码编译成了可以在Windows 98系统上运行的可执行文件,并成功实现了推理任务。

根据EXO的博客,在使用260K LLM和Llama架构时,生成速度达到了“35.9 tok/s”。当模型规模升级至15M LLM时,生成速度提升至略高于1 tok/s。尽管如此,当使用Llama 3.2 1B模型时,生成速度则显著下降,仅为0.0093 tok/s。这一实验展示了即使在资源极其有限的环境下,AI技术依然能够取得令人惊艳的成绩。

更多游戏资讯请关注:电玩帮游戏资讯专区

电玩帮图文攻略 www.vgover.com